Continuando a série sobre “Formação Cientista de Dados”, o curso de hoje é focado em “Engenharia de dados com Hadoop”. De forma resumida, Hadoop é uma solução open-source de processamento de dados que foi desenvolvida pela Apache Software Foundation, e tem como principal objetivo o processamento de dados com alto volume e variedade por meio de computação de larga escala, segundo o blog “Ciência e Dados”.

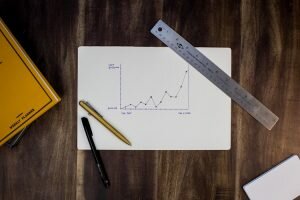

Com a chegada do Hadoop, o processamento massivo de dados começou a ser realizado de forma significativa por mais pessoas e empresas. Se você está no mercado de trabalho, já deve ter percebido que o volume de dados vem aumentando exponencialmente. Principalmente os dados não estruturados, como imagens, textos, gravações de vídeo ou áudio, que ainda não tenham sido codificados. Analisar esses dados será um dos maiores desafios nos próximos anos. E é aqui, que o Estatístico pode fazer a diferença. Acredite!

Os dados não estruturados compõem a rede; e os dados compartilhados nela, não param de aumentar. Se você tem uma vida social, por menos ativa que seja, está ajudando a aumentar o volume desse tipo de dados. E empresas como, Facebook, Instagram, Twitter, LinkedIn estão de “olho” no poder dessas informações. Ou você acredita que a Microsoft comprou o LinkedIn à toa? O que dizer das empresas que divulgam seus produtos e serviços no Snapchat?

E por que analisar esses dados é tão importante? Por que quem aprender novas tecnologias sairá na frente?

- As empresas estão ampliando a captação de dados estruturados e não estruturados, e o grande desafio será relacionar toda essa massa de dados, e transformá-los em informação. E isso pode acontecer em tempo real, como eu comentei no post anterior, sobre “Big Data Real-Time”.

- O Hadoop é uma ótima alternativa para tratar, processar e agrupar grandes volumes de dados estruturados, semiestruturados e não-estruturados. Ele permite extrair informações e fazer previsões a partir da compreensão de dados da empresa, ao invés de trabalhar apenas com dados armazenados.

- Estamos falando em lidar com petabytes de dados, e desenvolvimento de soluções inovadoras com informações geradas a partir da análise de big data. E isso é sensacional!

Como você já deve ter percebido os sistemas de armazenamento tradicionais não foram projetados para armazenar dados gerados em alta velocidade, alto volume e grande variedade; características presentes no Big Data. E um dos grandes desafios de um estatístico é analisar dados de forma mais rápida. Ou você nunca deixou de entregar um resultado porque o tempo disponível não foi suficiente para “rodar” uma programação?

Se você quiser saber um pouco mais sobre como melhorar as suas análises; resolver problemas mais complexos; analisar uma quantidade gigantesca de dados; e entender mais como a sociedade se comporta, abrace esse desafio, e vamos aprender juntos novas tecnologias.

Por que fazer?

As empresas estão gerando cada vez mais dados. E a velocidade com que esses dados são gerados aumenta a cada ano. E se você gosta de desafios, aqui vai mais 1: se você quiser acompanhar tudo isso, você precisa entregar resultados mais rápidos (significa aprender novas tecnologias, conceitos estatísticos mais avançados e conhecimentos de negócio). Como eu disse em outro post, hoje eu analiso muito mais informação, e entrego resultados mais rápidos do que 5 anos atrás. Como será daqui há 2 anos? Como você gera seus resultados hoje, e como pretende gerar em médio prazo?

Você deve estar se perguntando: mas eu preciso aprender Engenharia de Dados? Eu diria que se você quiser entender todo o universo do Cientista de Dados, minha resposta é SIM. Pois é o Engenheiro de Dados que “prepara o terreno”.

Em linhas gerais, ele foca no design, construção e manutenção dos sistemas que serão responsáveis por armazenar os dados que iremos analisar. Talvez você se identifique um pouco, se você for o responsável por criar layouts de captação de dados, escolher formatos e locais de armazenamento de dados, por exemplo.

E aí? Animado para entender um pouco mais desse universo e conhecer suas ferramentas?

O que eu vou aprender?

A proposta do curso é ensinar você a desenvolver soluções inovadoras de Big Data. No escopo estão desenhados conhecimentos do principal framework de Big Data, o Hadoop; conhecimentos de banco de dados NoSQL; jobs de mapeamento e redução; sistema de arquivos HDSF; cluster; e vai aprender a usar Spark com Hadoop, para criar soluções robustas.

No início do curso, você já vai perceber quais são os benefícios que as empresas terão ao utilizar o Hadoop, e qual a importância dessa tecnologia no processamento de um grande volume de dados. Vai aprender os conceitos de MapReduce, criar e executar alguns.

Resumidamente, o MapReduce é um modelo de programação que processa o Big Data, converte os dados em conjuntos de listas ordenadas, reduz o tamanho desses conjuntos, e gera listas menores. É como se você quebrasse um conjunto maior de dados, em vários pequenos pedaços.

Para ajudar com toda essa programação, conceitos estatísticos serão abordados, e você terá a oportunidade de relembrá-los, ou aplicá-los em uma nova realidade.

Modelagem Estatística, Inferência Indutiva (decision trees), Análise de Regressão e Estatística de Classificação (Random Forest), Naïve Bayes; Técnicas de Clustering: K-Means. Esses são apenas alguns temas que serão abordados nesse curso.

Esse mundo é novo para você? Para mim também! Mas fico muito animado com a possibilidade de aplicar conhecimentos estatísticos em outras dimensões, com é o caso do Big Data.

Onde posso aplicar?

Com esse conhecimento adquirido, você poderá aplicar suas análises em qualquer situação que exija análise de um grande volume de dados. Já pensou que tipo de decisões poderão ser tomadas, e quais serão os benefícios dessas ações?

Alguns exemplos de aplicações:

- Setor de Saúde: prever casos de doenças; detectar fraudes em convênios; melhorar a alocação de recursos; obter sugestões de diagnósticos. Essa área está em crescimento.

- Setor Financeiro: melhorar o desempenho dos investimentos; oferecer um mix de produtos melhor e personalizado; detectar e evitar fraudes.

- Setor de Telecomunicações: diminuir o churn; estimar demanda por serviço; recuperar ex-clientes; estimar o Lifetime Value (LTV).

- Setor de Turismo: atualização de preços de diárias de hotéis dinamicamente (Booking, Trivago, Expedia); gerenciar lugares disponíveis; detectar e evitar o overbooking.

Uma coisa você pode ter certeza: não faltarão dados para você colocar seu conhecimento em prática. Animado para se tornar um Cientista de Dados, e elevar seus conhecimentos em estatística a outro patamar?

P.S: Se você se interessou pelo curso, como eu me interessei, não perca tempo, e acesse o site da Data Science Academy para maiores informações. Esse curso específico começa dia 5 de setembro. E se você perdeu alguma matéria dessa série, é só clicar nos links abaixo:

Curso 1: Big Data Analytics com R e Microsoft Azure Machine Learning.

Curso 2: Big Data Real-Time Analytics com Python e Spark.

Material usado

Imagem de vários computadores: http://bit.ly/28PN12g

Siga-nos nas redes sociais

Facebook: https://www.facebook.com/oestatistico

Twitter:

Instagram:

Pinterest: